Sin embargo hay muy poco interés en informar, con un mínimo de detalle y transparencia, cómo se aplican los presupuestos existentes. Sobre todo en el capítulo de publicaciones científicas, que como veremos no son unos presupuestos tan magros.

Veremos que hay un gasto considerable en revistas científicas de pago (Elsevier y Clarivate, antes Thonsom-Reuters, gasto que se centra mayoritariamente en estas macroeditoriales ---oligopolios más bien--- , pero no exclusivamente), veremos igualmente si es necesario ese gasto, al menos en esa proporción. Y si responde a criterios de utilidad pública, a los intereses de la comunidad española y europea, y a los propios criterios de la investigación, los que hay que tener en cuenta para su desarrollo y fundamentación.

En conclusión, nos planteamos ¿qué es peor, que no se invierta o que lo que invertimos vaya a satisfacer fines no deseables, o incluso contrarios a lo que pretendemos? Si fuera lo segundo, podríamos concluir que sería mejor no invertir un céntimo de euro más de los contribuyentes españoles. Al menos hasta que no se racionalice esa inversión con arreglo a los intereses de la ciencia y de la comunidad nacional, y que se haga de una forma eficiente:

1. El coste y la eficiencia de la prestación.-

No hay, hasta donde sabemos, estudios que relacionen el coste, en sus diversas modalidades (acceso corporativo, acceso individual, acceso en comparación con el acceso a autoarchivos, …) con la eficiencia de dicho acceso medida o valorada en términos de rendimiento a través de investigaciones, calidad de éstas, o tan siguiera con índices de citación en otros trabajos científicos como medida de su influencia.

Sin embargo sí tenemos datos particulares sobre costes a centros y universidades seleccionadas de forma significativa. En particular sobre las inversiones hechas por el Centro de Investigaciones Energéticas, Medioambientales y Tecnológicas (CIEMAT).

Así por ejemplo tenemos datos publicados por Teknautas y El confidencial sobre cantidades pagadas por el CIEMAT a las editoriales de Elsevier entre 2014 y 2017, y por un Informe de Iberdidac, asociación empresarial del sector educativo español (Abril, 2018), sobre pagos del CIEMAT, universidades y otras administraciones españolas a editoriales científicas para dotar a bibliotecas.

En el primer caso, el servicio Teknautas y El confidencial, según declaran, lograron, tras muchas vicisitudes, tener acceso a la relación de cantidades que pagó en 2017 el CIEMAT por acceder a la editorial Elsevier y a las estadísticas individuales de consulta. A partir de esos datos dicen que “En total, la institución pagó 305.000 euros por la suscripción anual a 52 revistas del conglomerado editorial Elsevier, que se consultaron en no llega a 43.600 ocasiones en los trece meses que van entre enero de 2017 y de 2018.”

Como casos particulares señala

“La suscripción más barata fue a la revista 'Cell Stem Cell', sobre investigación en células madre. Pese a que el CIEMAT cuenta, a priori, con una rebaja en la suscripción, pagaron 1.928 euros por una suscripción de 12 meses en papel y digital. Para una persona cualquiera, una suscripción a la revista por los mismos conceptos cuesta 345 dólares o 280 euros. Es decir, el CIEMAT pagó 24 veces lo que usted pagaría por un año de 'Cell Stem Cell', que irónicamente no ofrece una opción de suscripción institucional.

La más cara fue una suscripción conjunta a dos revistas, 'Thin Solid Films' y 'Organic Electronics', por 17.953 euros. Más irónicamente aún, adquirir por separado estas dos revistas en una suscripción institucional saldría más económico a la institución: 17.140 euros.

Esto no empece para que Elsevier, en un giro difícilmente justificable desde su tradición y su modelo, opte, en consonancia con los nuevos tiempos y las nuevas corrientes de opinión de la comunidad científica y de las instituciones, por apoyar la edición propia en open access como una modalidad propia de edición, para quien así lo demande. De manera que muchas de las publicaciones y artículos, cuyo acceso vende, las ofrezca igualmente en modalidad de acceso abierto. Sin embargo, para paliar las posibles pérdidas que se deriven, cobra a los autores e indirectamente a las universidades lo que se llama significativamente el article processing charge (APC). Esta carga, en el caso de Elsevier, según los datos de la publicación de la Universidad de Cambridge Scholarly Communication (Comunicación Académica), en un especial dedicado al aumento del APC , que más abajo ofrecemos, supone pasar de cobrar 100 dólares por artículo a 5.000.

Hay que decir que muchos de los autores practicamos, como medio de revisión por pares y como metodología de trabajo científico, el autoarchivo. Esta práctica se lleva a cabo mediante preprints, blogs científicos, o redes sociales académicas. Subiendo borradores abiertos, o los propios artículos sometidos a debate y comentarios. En este último caso es lo que se conoce como autoarchivo, que se lproduce reduciendo el periodo de embargo que la revista o la editorial practica sobre el artículo, o simplemente eliminándolo como es el caso de RED. Constituye por otro lado, junto con los datos, los borradores y los contenidos de los debates, la literatura gris, la grey literature que subimos a Mendeley, Research Gate o Academia.edu, arXiv, eLis, OSF,… Son artículos que luego publicamos, o bien consultamos los de otros colegas que comparten sus artículos a pesar de publicarlos en revistas de Elsevier o de Clarivate. Esta forma de trabajar, considerada más productiva para el trabajo científico en redes, es lo que se llama opciones oro y verde del estándar Sherpa-Romeo, que en España se conoce como Dulcinea. Prácticas más eficientes y directas para la investigación y que de forma colateral hacen tanto más inútil el gasto de las universidades en suscripciones.

Pero volvamos a las grandes editoriales. No obstante los dicho, las universidades, los gobiernos, los órganos de decisión y de evaluación de la calidad en la producción científica (ANECA y CNEAI) y, todo hay que decirlo, un considerable sector de los propios investigadores argumentan que la edición en Elsevier y Clarivate proporciona una garantía de calidad que no ofrecen otros medios como las revistas publicadas por investigadores o asociaciones de investigadores, o los propios repositorios de universidades y de entidades públicas. Esta idea se traduce en que los fondos invertidos en suscripciones a revistas de Elsevier y de Clarivate son abono para la investigación. Constituye en definitiva una forma mimada y privilegiada de supuesto apoyo a la producción científica. Como consecuencia inevitable se piensa que los artículos indexados en Scopus o en WoS son de calidad en proporción al intervalo intercuartílico (lo que vulgarmente se llama cuartiles) donde están posicionados. Esta idea es trasmitida a las comisiones asesoras de evaluación de ANECA y de CNEAI. De hecho en España, y como copia mimética en Latinoamérica, los baremos de apoyo a la carrera investigadora establecen, como criterio preferente de calidad, los índices de Scopus y WoS, es decir de Elsevier y Clarivate. Así aparecen en las normas que regulan los sexenios y tramos de investigación, la acreditación para el acceso a los cuerpos y modalidades de desempeño universitario, la concesión de proyectos de investigación oficiales, etc.

Se podría decir en definitiva que invertir en suscripciones a Elsevier y a Clarivate es invertir en la investigación. Pero antes observemos los siguientes datos:

Fuente: Elaboración de El Confidencial. Created with Datawrapper.

En España las universidades han pagado casi lo mismo que en EE UU. Pero no obtenemos precisamente el mismo, o parecido, resultado. Hay notables diferencias en lo que obtienen las universidades de este país (Harvard, MIT, etc) y las españolas. Tampoco hay una correlación directa entre lo que invertimos y el resultado que obtenemos si comparamos España con países como Reino Unido (con universidades como Cambridge, Oxford, etc,), Alemania, Finlandia o Nueva Zelanda.

En España las universidades han pagado casi lo mismo que en EE UU. Pero no obtenemos precisamente el mismo, o parecido, resultado. Hay notables diferencias en lo que obtienen las universidades de este país (Harvard, MIT, etc) y las españolas. Tampoco hay una correlación directa entre lo que invertimos y el resultado que obtenemos si comparamos España con países como Reino Unido (con universidades como Cambridge, Oxford, etc,), Alemania, Finlandia o Nueva Zelanda.

En este estado de cosas, cuando la gente pide que se invierta más en investigación, implícitamente ¿no está pidiendo que se dé más dinero a Elsevier y a Clarivate? ¿Qué intereses hay detrás de las campañas de chain.org y similares? Al menos podríamos preguntarnos cui prodest ¿quién sale beneficiado con este estado de cosas? La pregunta vale igualmente para Brasil y Argentina.

Por lo demás esta tendencia es justo la contraria de lo que preconiza la UE:

Hay tres conceptos claves que la UE puso demanifiesto con énfasis y que recogí en el post Citación, calidad e innovación en edición científica, y en mis intervenciones en MEDES 2017 y en Lisboa (9th World Conference on Learning, Teaching and Educational Leadership): El autoarchivo, como garantía de que la edición en abierto respondía a la filosofía con la que se había creado y de la potencia de la investigación apoyada con los medios y entornos sociales y tecnológicos: Difundir la ciencia en el proceso de su investigación. Y sobre todo las prioridades de las opciones oro y verde de la difusión de la ciencia en abierto.

Sobre esto podemos ver lo dicho en otro post de este mismo blog.

El segundo documento a que hacíamos referencia es el informe de Iberdidac, asociación empresarial del sector educativo español (Abril, 2018) titulado "Informe demanda pública para el servicio de las bibliotecas de universidades públicas españolas".

Según él, éste es el gasto demandando en el concepto de revistas científicas digitales, dentro del plazo de tiempo transcurrido desde 2014 a la actualidad:

IMPORTE ANUAL DEMANDADO AÑOS 2014 – 2017

Con respecto a los dos últimos años los datos son los siguientes:

IMPORTE DEMANDADO POR ORGANISMO AÑO 2016

IMPORTE DEMANDADO POR ORGANISMO AÑO 2017

En ese mismo periodo la revista RED, con índice H5=19 y mediana H5=34, ha gasto 0 (CERO) euros, de un presupuesto asignado de 2.000€, pero que no se ha podido generar.

El total del CIEMAT por ese periodo es

IMPORTE DEMANDADO POR CIEMAT AÑOS 2014/2017

2. ¿Qué poderes e intereses hay detrás?

Teknautas es el suplemento de tecnología y ciencia del diario digital El Confidencial. No es nuestra tarea ahora juzgar la línea o la trayectoria periodística de estos medios. De ellos solamente tomamos las fuentes contrastadas, que citamos y a cuyos enlaces apuntamos. Es de elogiar en cualquier caso que hayan puesto a nuestra disposición estos datos. De esta forma la investigación llevada a cabo por Teknautas ha empezado a descubrir las fuentes y las cantidades del negocio que hay detrás de las publicaciones científicas.

Los datos están recopilados del Boletín Oficial del Estado (BOE), y están disponibles para su descarga en el repositorio de GitHub de la Unidad de Datos. Así, por ejemplo, en total, para el período 2012-2017 se pueden identificar 169 adjudicaciones para el suministro de revistas científicas en universidades, instituciones y consejerías autonómicas de Sanidad. Elsevier y EBSCO se han llevado más del 55% de los 213,44 millones de euros licitados para suscripciones en esos cinco años.

Los contratos de suministro de publicaciones científicas están disponibles en el fichero CSV de dirección: https://github.com/ECLaboratorio/datos/blob/master/contratos_suministro_publicaciones_cientificas.csv

Hubo una interpelación que llevaron a cabo los diputados de Ciudadanos Marta Martín Llaguno y Rodrigo Gómez que pasó completamente desapercibida en los medios académicos, y de la que hasta ahora desconocemos la respuesta.

En este caso la interpelación no plantea la política oficial de Open Access, ni la article processing charge (APC), y mucho menos la cuestión, la necesidad y las implicaciones que supone organizar la opción oro y verde del autoarchivo, tal como como plantea la UE, sino que sólo se plantea reducir el coste de las licencias corporativas a Elsevier, EBSCO, Clarivate, etc. La cuestión que pusieron sobre la mesa es: ¿por qué España paga más dinero en suscripciones que otros países como Finlandia y Alemania, y casi tanto como EE UU. Los diputados señalaron únicamente que España debiera adoptar una posición de fuerza similar a la que han planteado Finlandia y Alemania, y decían, respecto al modelo de negocio tradicional de Elsevier, que esta posición les ha servido para rebajar la factura a 9 millones de euros anuales, en el caso del país nórdico, y que los alemanes lleven disfrutando durante un año de las publicaciones científicas sin coste alguno, ahorrando de esta forma unos 10 millones anuales.

3. Ya el open acces no es, él solo, la solución

Con motivo de las elecciones a rector, que han tenido lugar recientemente en algunas universidades, entre otras en la de Murcia, hemos tratado esta cuestión en este blog. De ahí hemos sacado lo que sigue.

Hace más de diez años publicábamos esto sobre Acceso Abierto, y esto y esto también.

Entonces la difusión de investigaciones en Open Access estaba muy bien, era una opción avanzada, una alternativa a la rígida edición científica de las editoriales tradicionales que monopolizaban académica y económicamente los canales de difusión de la ciencia, ahogando la producción y la economía de las universidades y de los centros de investigación. Era una disrupción y un desafío frente el monopolio de las élites conservadoras académicas, para las cuales lo principal era la forma, la liturgia, de la literatura científica. En aquella época, para presentarte a la acreditación estatal de España, como profesor universitario, hacía falta presentar en papel y en cerrado tus publicaciones. Te rechazaban los artículos en formato electrónico y en acceso abierto porque (sic) los consideraban "sinónimo de baja calidad". A quien suscribe le sucedió. O peor aún, consideraban en esa época que el Open Access era un movimiento friki radical.

En 2005 publica Frederick J. Friend en RED EL APOYO DE LAS AGENCIAS DE FINANCIACIÓN DE LA INVESTIGACIÓN AL ACCESOABIERTO y Reme Melero Acceso abierto a las publicaciones científicas:definición, recursos, copyright e impacto, en El profesional de la información. En estos trabajos se demuestra con rigor que eso no era así, que el Open Access era una realidad tozuda que se impondría de forma inminente por la fuerza de los hechos. Así sucedió.

Fue a continuación. El Open Access fue aceptado como opción preferente o única, primero en grandes universidades de excelencia ---Havard, en 2008, MIT, en 2009, …--- y luego fueron las administraciones y agencias nacionales universitarias ---en UK, 2014, Alemania, en 2017, Francia, en 2016…--- las que impusieron el Acceso Abierto como forma preferente cuando no exclusiva, de publicar, frente a las políticas abusivas e insostenibles de las grandes editoras científicas.

Lo peor es que actualmente, como veremos, ya no es el acceso abierto lo importante: Los editores monopolistas le han dado la vuelta al asunto con el article processing charge (APC).

¿Cuál es la política oficial española respcto del Open Access en estas editoriales y sobre el APC?

En el último consejo de Gobierno del año pasado, el 29 de diciembre se aprobó el PLAN ESTATAL INVESTIGACIÓN CIENTÍFICA Y TÉCNICA Y DE INNOVACIÓN 2017-2020, (aquí está el PDF). En él se hacen consideraciones genéricas sobre la bondad del acceso abierto, pero sin diferenciar el que proporcionan las grandes editoriales (la modalidad preferida de publicación por las instancias oficiales, según los baremos y criterios de las convocatorias antes citadas de la CNAI, ANECA, etc) y el de las revistas editadas por profesores, departamentos, grupos de investigación o asociaciones universitarias. Y , esto es lo más importante, sin citar el autoarchivo (recomendado por la UE) ni tomar medidas para anular el efecto del article processing charge (APC), que empeora las cosas con relación a la situación anterior. Simplemente se hace una declaración hueca y voluntarista, sin contenido:

El Plan Estatal a través de las actuaciones que financia tiene como objetivo promover el acceso abierto a resultados y datos de la investigación así como impulsar un modelo de investigación responsable y abierta a la sociedad.

(…)

El impulso a la adopción de los principios de acceso abierto a los datos de investigación (FAIR27) por parte de las comunidades científicas e instituciones de investigación, y el reconocimiento de los trabajos publicados en acceso abierto en repositorios institucionales y temáticos como parte de la actividad investigadora y de los resultados de la investigación financiada a través del Plan Estatal.

Lo que no dejan de ser declaraciones sin contenido concreto. Ya que, dicho así, lo único que hará este plan será compensar mediante el crecimiento astronómico del article processing charge (APC) a las editoriales por la supuesta disminución de ingresos que suponen estos conceptos. A esto es lo que se dedicarán importantes inversiones, más aún de las que ahora hay, que superan las del Reino Unido o Alemania.

No podemos por menos que preguntarnos una vez más si cuando se pide que se aumenten los fondos dedicados a la investigación ¿realmente se está diciendo que se entregue dinero a espuertas en concepto de APC a las grandes editoriales?

Y si no fíjense lo que ha sucedido ya, y lo que viene. La publicación de la Universidad de Cambridge Scholarly Communication (Comunicación Académica), en un especial dedicado al aumento del APC que han establecido las editoriales atribuido a open acces, da los siguientes datos:

Publishers' Open Access article processing charges

Publisher

|

APC from

|

APC to

|

Fully OA or Hybrid?

|

$5000*

|

$5000

|

Hybrid

| |

$705

|

$2770

|

Open Access

| |

$600

|

$2700

|

Hybrid

| |

$100

|

$5000

|

Hybrid

| |

$400

|

$2250

|

Open Access

| |

CHF 150

|

CHF 1800

|

Open Access

| |

£890

|

£3,150

|

Hybrid

| |

$1495

|

$2900

|

Open Access

| |

$750

|

$3000

|

Hybrid

| |

$3000

|

$3000

|

Hybrid

| |

$500

|

$2950

|

Open Access

| |

$800

|

$5200

|

Hybrid

|

Sólo como ejemplo:

Elsevier pasa de $100 a $5000.

SAGE de $750 a $3000

Taylor and Francis de $500 a $2950.

Wiley de $800 a $5200

Esta perspectiva no sólo no es tenida en cuenta en el documento citado, sino que ni tan siquiera se menciona.

Contrasta este tratamiento con el que le da la Unión Europea y el propio comisario Moedas, tal como lo reseñé en el post “Citación, calidad e innovación en edición científica” sobre la política 2020 europea proclamada por el propio comisario del ramo, de la que se hace eco la revista Nature en un artículo titulado In dramatic statement, European leaders call for ‘immediate’ open access to all scientific papers by 2020.

En él se dice

What the European Union needs to do is require that its scientific output is deposited in institutional repositories, an option called Green OA. The Dutch government favors Gold OA, in which authors publish in an OA journal; the council does not express a preference for either route.

Lo que la Unión Europea necesita hacer es exigir que su producción científica se deposite en repositorios institucionales en una opción llamada Green OA (Opción verde: Autoarchivo antes y después de la publicación por los autores o por las repositorios). El gobierno holandés favorece Gold OA (Opción oro o amarilla: Autoarchivo después de la publicación por los autores o por las repositorios), en el que los autores publican en un diario de OA; el consejo no expresa una preferencia por ninguna de las rutas.

Donde se señala de forma clara la necesidad del autoarchivo en cualquiera de los casos.

Para los legos éstas son las opciones de calidad en la edición científica del Open Access conocidas como los estándares Sherpa Romeo, en España Proyecto Dulcinea. Las explicamos igualmente en el post “Citación, calidad e innovación en edición científica”

4. ¿A qué intereses y criterios obedecen las grandes editoriales de las revistas científicas?

5. ¿Qué ciencia, qué artículos y qué revistas están y de cuales se computan las citas en Wos y Elsevier?

6. ¿Reflejan la realidad los índices de impacto de WoS y de Scopus?

Así por ejemplo los titulares de Google Scholar Digest y de su perfil en Twitter, que son miembros del equipo EC3 de la Universidad de Granada, se plantean cosas como las que siguen:

Sobre el Ranking REDIB dicen que, si su objetivo es cubrir el ámbito iberoamericano de revistas científicas, ¿cuál es la representación de 947, las de Clarivate-REDIB, sobre las 19.789 inventariadas en el Directorio Latindex o las 7.761 del Catálogo Latindex?

Y sobre todo habría que decir, por qué lo hacen exclusivamente con las citas en WoS?

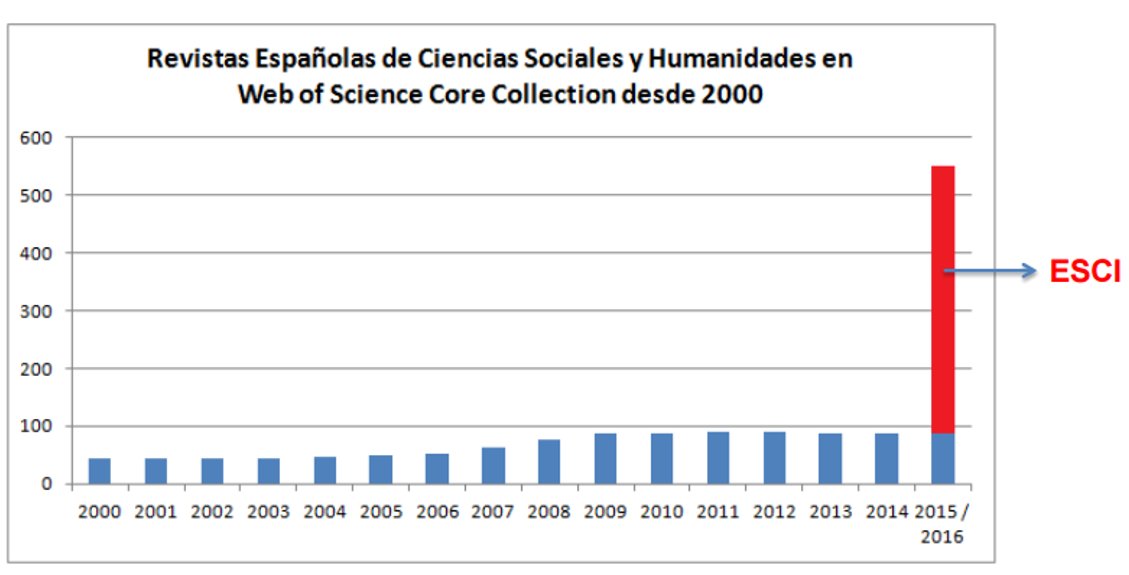

La política de Clarivate en ESCI, su SALA DE EMERGENCIAS, está clara. Con 7340 revistas ya indizadas el lema es ¡cuántas más mejor! Emulando a Scopus, abrió la puerta trasera de Web of Science a cualquier revista que se le puso a tiro. En fin de selecto club a club de campo...

Pero lo que ya es definitivo, y sobre todo coincide en grado extremo, superándolo incluso, con lo que hemos dicho sobre las correlaciones de Pearson NEGATIVAS señaladas anteriormente es lo que dicen en este tuit:

Pero no todo está perdido, sobre todo si esta fuerza y estos recursos que pueden detraerse de una buena negociación con las grandes corporaciones editoriales, puede aplicarse sin duplicaciones, a esfuerzos ya iniciados, como pueden ser los que hacen FECYT con su homologación de revistas, que nadie critica, y con la ingente base de datos (con citación y cómputo de índices transparente, sensible a las erratas y modificable) como es la de Google Scholar y sus métricas. Y sobre todo contando con la experiencia y la seriedad en trabajos de investigación como son los de EC3 o los de desarrollo en otro ámbito como es el del grupo de investigación y desarrollo en webmetría, liderado por Isidro Aguillo, Cybermetrics Lab, en el CSIC para elaborar el a partir de los datos de GSM el ranking de universidades en la web (webmetrics).

La propuesta que hacemos es la de confeccionar un ranking en base a las revistas homologadas por FECYT, sobre los datos de GS, revisados por un grupo como EC3 y con un soporte tecnológico y metodológico como el del Cybermetrics Lab, en el CSIC. En esa línea, un paso a la estandarización y a la internacionalización sería aceptar y tomar como referencia las áreas temáticas de GSM, con su organización en categorías y subcategorias, evitando duplicidades e imputación de citas de un área en otra, tal como se verifica en el ranking de REDIB.

Tenemos recursos y materia gris ¿por qué no hacerlo?

4. ¿A qué intereses y criterios obedecen las grandes editoriales de las revistas científicas?

Recientemente se ha firmado, y ahora se ha hecho público, un acuerdo entre Clarivate (antes Thomson-Reuters),de una parte, y REDIB-CSIC, de otra. Hay que recordar que en sus inicios el repositorio REDIB se nutrió de las revistas indexadas en E-REVISTAS,plataforma que fundamos un grupo de editores al amparo de CINDOC-CSIC y de lasredes de discusión científica de Red Iris, también del CSIC. Hay que decir que en esas discusiones y en ese proceso me cupo el privilegio de participar, y de cuyo recuerda aún persiste el foro del proyecto inicial compuesto por medio centenar de editores de revistas de acceso abierto, es el foro E-REVISTAS del servicio de listas de Red Iris, redacadémica española.

Este acuerdo, el firmado y hecho público ahora, supone aceptar por medios públicos españoles y validar, con repercusión en la promoción de personas y de proyectos, la metodología para la evaluación de publicaciones que Clarivate ofrece (el famoso impact factor, IF, con el que se elabora el Journal Citation Report, el JCR) para aplicarlo a las revistas de Iberoamérica incluidas en WoS, es decir mayoritariamente a las revistas del índice donde Clarivate acogió, sin explicar muy bien con qué criterios, como vamos a ver, a prácticamente la todas las revistas que solicitaron ser evaluadas e incluidas en JCR , es decir a las revistas acogidas en el Emerging Sources Citation Index (ESCI).

Resumiendo, Clarivate, con el aval del CSIC y de la administración española, y con el apoyo de su infraestructura y medios, ha creado un ranking en el que se ofrece una valoración y una prelación de las revistas españolas, portuguesas e iberoamericanas que están ya incluidas en en la Core-Collection de la WoS, es decir sólo las que están en Clarivate. Valoración hecha, como después veremos, exclusivamente a partir de las citas que de esas publicaciones se hacen en la misma WoS. Y con una metodología opaca, cuyos criterios apenas podemos entrever a través de los casos que conocemos y de las escasas justificaciones que ofrecen para sus decisiones.

Dentro de esos casos, en lo que sigue, vamos a relatar algo del procedimiento seguido con RED. Y después analizaremos el procedimiento y los resultados a partir de los datos hechos públicos y de otras valoraciones que se han públicas en medios especializados.

Con fecha 1 de octubre de 2015 recibimos este mensaje de Nancy Thornton, Editor - Editorial Development de Thomson Reuters. En él, como se puede leer, se nos comunicaba la inclusión de RED en el Emerging Sources Citation Index (ESCI). En dicho mensaje se dice:

While RED-Revista de Educacion a Distancia continues to be evaluated for WoS Core products, Thomson Reuters has accepted it for a new edition of Web of Science launching this November.

The new edition, called the Emerging Sources Citation Index, will make your content discoverable and citable on Web of Science while the journal undergoes its more rigorous evaluation for the WoS core.

El día 25 de Enero recibimos este mensaje de Thomas A. Ciavarella, Manager, Publisher Relations de Thomson Reuters, con copia a Nancy Thornton, Editor at Thomson Reuters Corporation, en el que se nos comunicaba el comienzo de la indexación de artículos de RED (We will proceed with indexing) con esa fecha

Después, WoS empezó a incluir nombres de revistas en la lista MASTER JOURNAL LIST, en el apartado correspondiente a ESCI, incluso creó un acceso a la lista completa. En esa lista, como resultado de la búsqueda no apareció RED. Pedimos aclaraciones, y éste es el mensaje recibido de Thomas A. Ciavarella, Manager, Publisher Relations de Thomson Reuters, con copia a Nancy Thornton:

Dear Miguel,

We have accepted the journal for our new Emerging Sources Citation Index. The 2015 content of the journal is being processed by our Web of Science indexing team. Processing takes a few weeks to complete.

Our Master Journal List is updated with the names of newly processed journals. Your journal will appear on the Master Journal List when we have processed its content.

Separately, you will receive a formal notification of coverage from the Publisher Relations team via email. If you have questions in the meantime, please be in touch.

Thank you for joining us in this new venture.

Best,

- Tom

· · · · · · · · · · · · · · · · · · · · · · · · · · · · · · · · · · · · · · ·

Thomas A. Ciavarella

Manager, Publisher RelationsThomson Reuters

En estos mensajes podemos seguir más o menos las incidencias de cómo se inició el proceso y de las conceptualizaciones y datos que se nos ofrecieron y se nos prometieron.

Hay que decir que RED, según las métricas de Google Scholar (GSM), que son absolutamente transparentes porque permiten ver una por una todas las citas de todos los artículos, con el rigor que Harzing explica, está clasificada, con un índice H5= 19 y una Mediana H5=34, en la posición 17 de las revistas científicas que se publican en español (total o parcialmente) y en la posición 26 de las revistas científicas internacionales de su especialidad.

Como final, por ahora, del proceso, en fecha reciente, se nos comunica las exclusión de RED del JCR

Este es el mensaje de Clarivate/ Thonsom – Reuters:

________________________________________________________________

Dear Miguel,

Thank you for following up. I hope you're well.

Our editors evaluated your journal for the Social Science Citation Index a few months ago. Unfortunately, the citation record for RED does not compare favorably to that of our existing education coverage in Web of Science; this is a well-covered category.

Furthermore, the citation activity is lower than that of similar journals from Spain and journals focusing on distance education.

As such, we have decided not to add RED to SSCI at this time. Coverage will continue in the Emerging Sources Citation Index, and the journal will be scheduled for re-evaluation.

Please be in touch if you have questions. And please note our new email addresses; they end in @clarivate.com.

Best,

Manager, Publisher Relations | Clarivate Analytics

-----------------------------------------------------------------------------------------

Que traducido es más o menos así:

Querido Miguel,

Gracias por el seguimiento. Espero que estés bien.

Nuestros editores evaluaron su revista para el Social Science Citation Index hace unos meses. Desafortunadamente, el registro de citaciones para RED no se compara favorablemente con el de nuestra cobertura educativa existente en Web of Science; esta es una categoría bien cubierta.

Además, la actividad de citas es más baja que la de revistas similares de España y las revistas que se centran en la educación a distancia.

Como tal, hemos decidido no agregar RED a SSCI en este momento. La cobertura continuará en el Índice de citas de fuentes emergentes, y la revista se programará para una nueva evaluación.

Por favor, póngase en contacto si tiene preguntas. Y tenga en cuenta nuestras nuevas direcciones de correo electrónico; terminan en @clarivate.com.

Saludos,

----------------------------------------

Llaman la atención dos expresiones:

the citation record for RED does not compare favorably to that of our existing education coverage in Web of Science; this is a well-covered category.

(el registro de citaciones de RED no sale favorecido si se compara con el de nuestra cobertura educativa existente en Web of Science; ésta es una categoría bien cubierta.)

Es decir, esa franja la tienen bien cubierta, y la revista carece de interés para ellos. Sin precisar si se refieren a España, el mundo hispano o el ámbito global. Sobre esto haremos las precisiones después y en el apartado siguiente.

Ése es su dictamen sin entrar en más discernimiento ni en otras consideraciones sobre el interés específico, el enfoque, la orientación, las tendencias, la calidad en función de la eficiencia (en este caso los resultados de las investigaciones ni su proyección), el carácter social,…

El otro párrafo que merece la pena tener en cuenta es

Furthermore, the citation activity is lower than that of similar journals from Spain and journals focusing on distance education.

(Además, la actividad de citas es más baja que la de revistas similares de España y las revistas que se centran en la educación a distancia.)

Pero ese va a ser la base del apartado siguiente.

5. ¿Qué ciencia, qué artículos y qué revistas están y de cuales se computan las citas en Wos y Elsevier?

5.1

Como hemos visto, RED fue incluida en ESCI, y así nos lo comunicaron, el 1 de Octubre de 2015. Mucho después, a principios de 2017 indexan algunos artículos, después incluso de indexar las últimas revistas admitidas en ESCI, algunas casi sin citación en GSM. La indexación de RED en Core Collection, la hicieron, tras mucho pedirlo, a principios de 2017, un año y cuatro meses después de comunicar la inclusión en el índice. Pero sólo indexan los artículos de 2015.

Tras un prolijo intercambio de mensajes acceden a indexar en diciembre de 2017 el número 54, publicado en junio de 2017, pero no lo hacen así con números anteriores: el 52 y el 53. Con lo cual:

- El 54 no da tiempo a ser computado como artículo de ESCI-WoS en 2017.

- El 52 y el 53, que son los otros dos de 2017, no los indexan tampoco en 2017

- El año 2017 está en blanco en citas, y ahora estamos en 2018: en él no hay nada.

- El número 46, especial sobre pensamiento computacional y que es el que más citas recibe, no se computa hasta 2017 por tanto el grueso de citas de artículos señeros como el de Walter Bender, que se producen en 2015 y 2016 tampoco se computan

Desconozco al detalle los caso de revistas tan prestigiosas como Revista de Investigación Educativa, Education in the Knowledge Society o RIFOP, pero el resultado visible es similar al de RED.

5.2

En toda esta peripecia hemos podido constatar además que WoS no tiene en cuenta las citas que vienen de fuera de su base de datos.

Tampoco las que provienen de preprints, TFM, tesis doctorales (aunque tenga un repositorio específico para algunas de esas modalidades y temas, pero la mayor parte está fuera, está en los repositorios institucionales, como Dialnet o Teseo, y en los repositorios de las universidades y centros de investigación. Y tampoco para los resultados de proyectos.

Éste hecho supone un desconocimiento deliberado, cuando no un desprecio, del carácter validador y evaluador hecho directores y tutores de tesis, de TFC, TFG y TFM, y de otros agentes como son los que revisan y validan los preprints, los advisors de las redes científicas como Research Gate, Mendeley, etc. y de los propios editores de las revistas fuera del circuito de Clarivate.

Queda constancia pues, a partir de este caso y de otros puestos de manifiesto en las métricas publicadas por Comunicar como después veremos, que en el caso de ESCI, WoS ha estado incluyendo y dejando de incluir ¿arbitrariamente? artículos y números completos de revistas. Eso ha sucedido, como hemos visto con la nuestra y otras revistas de Educación Aprendizaje, Investigación Educativa,… En el caso nuestro tenemos toda la comunicación intercambiada entre el gestor de relación con los editores y un miembro del consejo técnico, el que ha tenido que estar tras ellos reclamando y negociando la inclusión de números, tras comprobar que a nuestra revista de forma reiterada dejaban de incluirla.

6. ¿Reflejan la realidad los índices de impacto de WoS y de Scopus?

A partir de los datos recopilados[1] por el grupo Comunicar[2] (a los cuales agradecemos su trabajo, aunque venga sin firmar de forma académica y sin constatar metodología y fuente ni referencia alguna) hemos confeccionado de forma urgente esta hoja de cálculo. Obviamente es incompleta y susceptible de ser completada, pero sirve para evidenciar un hecho: y es que la correlación ni tan siquiera es nula, lo cual señalaría que no existe ninguna dependencia ni relación entre ambos índices, el IF de WoS y el H5 de GMS, sino que, más allá, es SIGNIFICATIVAMENTE NEGATIVA.

Hace pues sospechar fundadamente que existe una RELACIÓN NEGATIVA entre ambos índices, particularmente con la Mediana H5, bajo nuestro punto de vista el índice más significativo, pero también clara y notable con el índice h5. Es decir al aumentar el FACTOR DE IMPACTO disminuye el INDICE H5:

Hoja de cálculo con coeficientes de correlación de Pearson.

REVISTA

|

Cuartil

|

Impact factor

|

Percentil

|

H5

|

Med H5

| ||||||

REDU-REVISTA DE DOCENCIA UNIVERSITARIA

|

Q3

|

0,248

|

46

|

21

|

30

| ||||||

PIXEL-BIT- REVISTA DE MEDIOS Y EDUCACION

|

Q3

|

0,157

|

37

|

20

|

30

| ||||||

RED-REVISTA DE EDUCACION A DISTANCIA

|

Q4

|

0,04

|

18

|

19

|

34

| ||||||

REVISTA DE INVESTIGACION EN EDUCACION

|

Q4

|

0,075

|

24

|

15

|

20

| ||||||

RIED-REVISTA IBEROAMERICANA DE EDUCACION A DISTANCIA

|

Q1

|

1,069

|

94

|

13

|

19

| ||||||

REVISTA EUREKA SOBRE ENSENANZA Y DIVULGACION DE LAS CIENCIAS

|

Q2

|

0,553

|

73

|

12

|

17

|

Corr IF/H5 =

|

-0,282666

| ||||

OPEN PRAXIS

|

Q1

|

0,733

|

84

|

12

|

19

| ||||||

REVISTA INTERUNIVERSITARIA DE FORMACION DEL PROFESORADO-RIFOP

|

0

|

12

|

18

| ||||||||

RELIEVE-REVISTA ELECTRONICA DE INVESTIGACION Y EVALUACION EDUCATIVA

|

Q2

|

0,563

|

74

|

11

|

15

|

Corr IF/Med H5=

|

-0,3081524

| ||||

RIE-REVISTA DE INVESTIGACION EDUCATIVA

|

Q1

|

0,862

|

89

|

11

|

16

| ||||||

BORDON-REVISTA DE PEDAGOGIA

|

Q3

|

0,267

|

49

|

10

|

20

| ||||||

JOURNAL OF NEW APPROACHES IN EDUCATIONAL RESEARCH

|

Q1

|

1,541

|

98

|

9

|

14

| ||||||

FORO DE EDUCACION

|

Q2

|

0,559

|

73

|

7

|

9

| ||||||

En esta misma línea, con reservas sobre el ranking y con estudios que siguen evidenciando la falta de correlación entre WoS, Elsevier-Scopus y GSM, se manifiestan los componentes del grupo EC3 que escriben el blog Google Scholar Digest y mantienen su perfil en Twitter.

Sobre el Ranking REDIB dicen que, si su objetivo es cubrir el ámbito iberoamericano de revistas científicas, ¿cuál es la representación de 947, las de Clarivate-REDIB, sobre las 19.789 inventariadas en el Directorio Latindex o las 7.761 del Catálogo Latindex?

¿Si REDIB indexa 2.345 revistas ¿por qué calcular solo el impacto de 947? Y sobre todo por qué esa ofensa a las revistas de REDIB que están mal evaluadas por WoS con respecto a GSM, añadiríamos nosotros.

Y sobre todo habría que decir, por qué lo hacen exclusivamente con las citas en WoS?

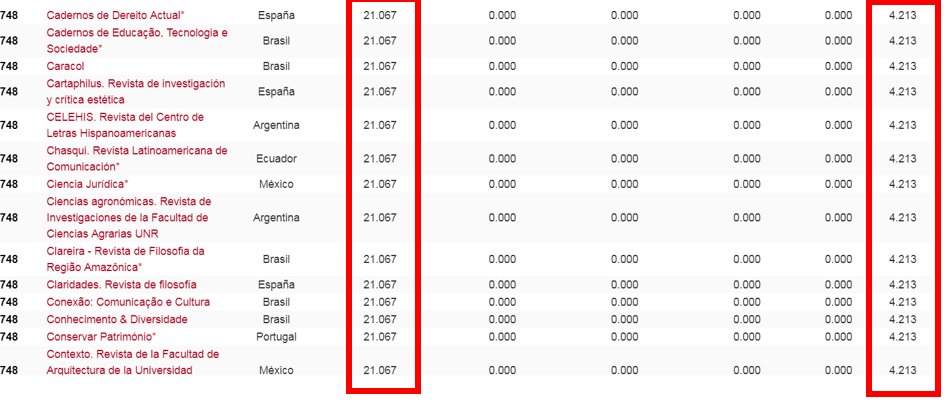

La política de Clarivate en ESCI, su SALA DE EMERGENCIAS, está clara. Con 7340 revistas ya indizadas el lema es ¡cuántas más mejor! Emulando a Scopus, abrió la puerta trasera de Web of Science a cualquier revista que se le puso a tiro. En fin de selecto club a club de campo...

Pero lo que ya es definitivo, y sobre todo coincide en grado extremo, superándolo incluso, con lo que hemos dicho sobre las correlaciones de Pearson NEGATIVAS señaladas anteriormente es lo que dicen en este tuit:

Visible en la tabla:

En épocas pasadas hemos sostenido disensiones y críticas con este grupo, el EC3 Evaluación de la ciencia y de la comunicación científica, pero ahora no podemos por menos que elogiar su trabajo, la seriedad y la independencia de su análisis en este caso y animarles a que sigan en este empeño. Sobre todo a los titulares del blog (Google Scholar digest) Juan Manuel Ayllón Millán, Emilio Delgado López-Cózar, Alberto Martín Martín y Enrique Orduña Malea

Pero no todo está perdido, sobre todo si esta fuerza y estos recursos que pueden detraerse de una buena negociación con las grandes corporaciones editoriales, puede aplicarse sin duplicaciones, a esfuerzos ya iniciados, como pueden ser los que hacen FECYT con su homologación de revistas, que nadie critica, y con la ingente base de datos (con citación y cómputo de índices transparente, sensible a las erratas y modificable) como es la de Google Scholar y sus métricas. Y sobre todo contando con la experiencia y la seriedad en trabajos de investigación como son los de EC3 o los de desarrollo en otro ámbito como es el del grupo de investigación y desarrollo en webmetría, liderado por Isidro Aguillo, Cybermetrics Lab, en el CSIC para elaborar el a partir de los datos de GSM el ranking de universidades en la web (webmetrics).

La propuesta que hacemos es la de confeccionar un ranking en base a las revistas homologadas por FECYT, sobre los datos de GS, revisados por un grupo como EC3 y con un soporte tecnológico y metodológico como el del Cybermetrics Lab, en el CSIC. En esa línea, un paso a la estandarización y a la internacionalización sería aceptar y tomar como referencia las áreas temáticas de GSM, con su organización en categorías y subcategorias, evitando duplicidades e imputación de citas de un área en otra, tal como se verifica en el ranking de REDIB.

Tenemos recursos y materia gris ¿por qué no hacerlo?

[2] Los mismos autores reconocen las limitaciones de la lista ordenada y de la validez de los índices obtenidos que atribuyen a WoS (estos siempre indican que son provisionales, aunque los publican en su base de datos Core Collection) en los comentarios que incluyen al pie de la lista:

“El presente documento es una simulación que pretende visualizar cómo se posicionarían las revistas de las categorías de Educación y Comunicación de Emerging Source Citation Index (ESCI) de acuerdo a su Factor de Impacto para el año 2017.

(…) Los datos han sido calculados según las citas que reciben los artículos en Web of Science Core Collection. La carga y cálculo de datos se ha llevado a cabo en abril de 2018, por lo que, aunque los datos para obtener los indicadores ya están publicados siguen estando sujetos a correcciones y modificaciones por parte de Web of Science. Hay que aclarar que "Comunicar" no tiene ninguna relación con Clarivate Analytics y que por tanto este documento carece de valor oficial.”