En los últimos procesos de valoración de méritos docentes e investigadores organizados por la ANECA se han utilizado para la baremación listas de las publicaciones científicas, que gozan del certificado de la FECYT, ordenadas con un número de posición cuya génesis desconocemos, a las que se ha asignado una inclusión en intervalos intercuartílicos (los clásicos Q1, Q2, Q3 y Q4).

Más abajo reproducimos las listas de las revistas, rankeadas así, por áreas.

Pero antes convendría realizar algunas precisiones que no por obvias son menos necesarias, en función de lo que hemos visto y oído decir.

En los procesos de valoración que hacen las agencias de los ranking, la asignación de los Q1, Q2, Q3 y Q4 (vulgarmente conocidos como cuartiles) a las revistas NO SON FRUTO DE UNA DECISIÓN ARBITRARIA, NI SURGEN COMO ASIGNACIÓN DE UNA MARCA O DE UN PREMIO EN FUNCIÓN DE UNOS CRITERIOS ESTABLECIDOS POR UNA INSTANCIA OFICIAL, UNA AGENCIA O UN TRIBUNAL DE MÉRITOS. Es algo que se obtiene, de una forma predeterminada mediante un procedimiento universalmente conocido y aceptado, a partir de la distribución de una variable obtenida por un procedimiento empírico de recuento de datos, manual o mecanizado.

Estadísticamente, los cuartiles SON MEDIDAS DE TENDENCIAS DE AGRUPAMIENTO DE DATOS EN UNA DISTRIBUCIÓN DE FRECUENCIAS de una variable estadística. Como lo son los deciles, centiles ---o percentiles--- quintiles, sextiles,... y también la mediana, que se llama así pero que es de la misma naturaleza que los demás, aunque, como la población en este caso se divide en dos, se considere una medida de tendencia central.

Bibliométricamente, los índices de citación o de impacto y otros, que se atribuyen a las revistas, constituyen una variable estadística de este tipo, pero donde la frecuencia absoluta de cada valor de la variable, revista, es 1.

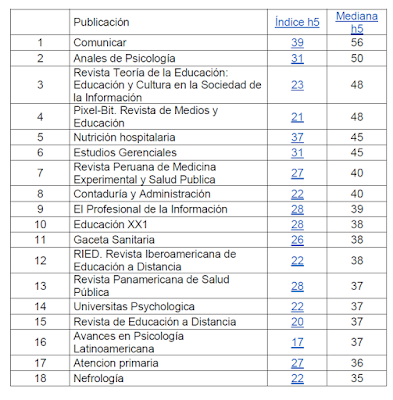

El procedimiento para obtener los cuartiles y los intervalos intercuartílicos es muy simple: Se ordenan las revistas de mayor a menor índice, o por la valoración asignada en función de varios índices y criterios.

Siendo n el número de revistas (tamaño de la población) se toman n/4, 2n/4, y 3n/4 como valores que definen los límites de los intervalos intercuartílicos (Al no ser una variable númerica el cuartil no existe). Si n=17, esos valores son 4,25 8,5 y 12,75 . La revista número 4 es Q1 y la 5 es Q2, la número 8 es Q2 y la 9 es Q3, y así sucesivamente.

Como observación adicional, sin interés específico para este caso, si la variable fuese numérica el valor del cuartil sería el valor de la variable cuya frecuencia acumulada (distribución) fuese respectivamente n/4, 2n/4 y 3n/4, con lo cual el valor de la función de distribución no tendría más de dos decimales pero no así sucede con los cuartiles, valores de la variable correspondientes a esos valores de la función, sino que podría se cualquier número real, bien directamente estimado o bien por interpolación de los dos datos directamente estimados más próximos a él por arriba y por debajo.

Todo esto puede obtenerse o ampliarse de forma más precisa y rigurosa en los siguientes enlaces:

De Blibliometría

De Estadística

En las listas que hemos obtenido, cedidas por miembros de comisiones de evaluación, donde las revistas vienen con la posición y el Q asignado, se ha hecho el recuento y la siguiente distribución por cuartiles:

|

Q1

|

Q2

|

Q3

|

Q4

|

TOTAL (n)

|

n/4

|

Sociales

|

26

|

27

|

27

|

26

|

106

|

26,5

|

Juridicas

|

4

|

5

|

3

|

5

|

17

|

4,25

|

CC Vida

|

5

|

6

|

5

|

6

|

22

|

5,5

|

CC Puras e Ing

|

7

|

7

|

7

|

8

|

29

|

7,25

|

Humanidades

|

30

|

31

|

30

|

31

|

122

|

30,5

|

|

|

|

|

|

|

|

TOTAL

|

|

|

|

|

296

|

|

En las tablas que compartimos vemos que todo se ajusta, excepto Ciencias Jurídicas, donde se asigna Q2 hay cinco revistas y Q3 a 3. La marca está en 8,5. Luego la revista de la posición 9 debería estar en el intervalo Q3 y está en el Q2.

En general compartimos lo que se dice en el post de Remiso acerca de cuáles deben ser las características de un proceso como éste y de que no se cumplen en este caso. Coincimos además en la gravedad del asunto.

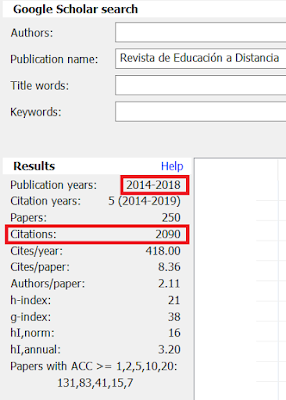

Siempre hemos defendido la necesidad de un ranking de excelencia español sobre la base de las revistas con sello FECYT y con un indicador mezcla de H y de otros. Pero de forma convergente, siguiendo la teoría de Martin (1996).

Y por supuesto con separación por áreas y dominios HOMOGÉNEOS (como son las categorías y subcategorías de GSM en inglés), porque cada área tiene una escala propia. Y no como sucede en GSM en español y en Dialnet donde hay revistas de dos disciplinas que están rankeadas en dos áreas, sumando en cada una de las listas las citas de la otra. Algo que el autor del post citado ha visto y ve bien en otras ocasiones y en este caso no.

En resumen, creo que una lista de ese tipo, como lo es la constituida por las revistas de FECYT con ese indicador convergente, debiera existir con un proceso de elaboración que reuniese todas las garantías de rigor científico y de publicidad.

Estas son las listas utilizadas en las comisiones de valoración:

1 Ciencias Sociales

2 Ciencias Jurídicas

3 Ciencias puras e ingenierías

4 Ciencias de la vida

5 Humanidades

Referencias

Martin, B. R., & Irvine, J. (1983). Assessing basic research: some partial indicators of scientific progress in radio astronomy. Research policy, 12(2), 61-90. Assessing basic research: some partial indicators of scientific progress in radio astronomy. Research policy, 12(2), 61-90.

Martin, B. (1996). The use of multiple indicators in the assessment of basic research.

Martín-Martín, A., Orduna-Malea, E., Thelwall, M., & López-Cózar, E. D. (2018). Google Scholar, Web of Science, and Scopus: A systematic comparison of citations in 252 subject categories. Journal of Informetrics, 12(4), 1160-1177. Journal of Informetrics, vol. 12, no. 4, pp. 1160-1177, 2018. https://doi.org/10.1016/J.JOI.2018.09.002. https://osf.io/preprints/socarxiv/42nkm/ , https://arxiv.org/ftp/arxiv/papers/1808/1808.05053.pdf